天垓 100 率先完成百亿级参数大模型训练,天数智芯迎来新的里程碑

6 月 10 日,在第五届智源大会 AI 系统分论坛上,上海天数智芯半导体有限公司(以下简称“天数智芯”)对外宣布,在天垓 100 加速卡的算力集群,基于北京智源人工智能研究院(以下简称“智源研究院”)70 亿参数的 Aquila 语言基础模型,使用代码数据进行继续训练,稳定运行 19 天,模型收敛效果符合预期,证明天数智芯有支持百亿级参数大模型训练的能力。

图天数智芯产品线总监宋煜

在北京市海淀区的大力支持下,智源研究院、天数智芯与爱特云翔共同合作,联手开展基于自主通用 GPU 的大模型 CodeGen(高效编码)项目,通过中文描述来生成可用的 C、Java、Python 代码以实现高效编码。智源研究院负责算法设计、训练框架开发、大模型的训练与调优,天数智芯负责提供天垓 100 加速卡、构建算力集群及全程技术支持,爱特云翔负责提供算存网基础硬件及智能化运维服务。

图天数智芯大模型训练全栈方案

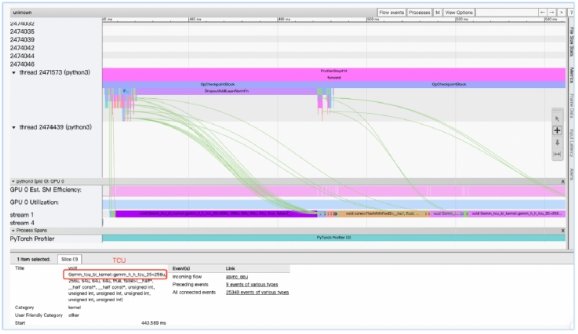

在三方的共同努力下,在基于天垓 100 加速卡的算力集群上,100B Tokens 编程语料、70 亿参数量的 AquilaCode 大模型参数优化工作结果显示,1 个 Epoch 后 loss 下降到 0.8,训练速度达到 87K Tokens / s,线性加速比高达 95% 以上。与国际主流的 A100 加速卡集群相比,天垓 100 加速卡集群的收敛效果、训练速度、线性加速比相当,稳定性更优。在 HumanEval 基准数据集上,以 Pass@1 作为评估指标,自主算力集群训练出来的模型测试结果达到相近参数级别大模型的 SOTA 水平,在 AI 编程能力与国际主流 GPU 产品训练结果相近。

图基于天垓 100 算力集群的 AquilaCode 大模型训练性能采样

天垓 100 率先完成百亿级参数大模型训练,迈出了自主通用 GPU 大模型应用的重要的一步。这一成果充分证明了天垓产品可以支持大模型训练,打通了国内大模型创新发展的关键“堵点”,对于我国大模型自主生态建设、产业链安全保障具有十分重大的意义。

接下来,天数智芯将与合作伙伴们继续深入合作,建设更大规模的天垓 100 算力集群,完成更大参数规模的大模型训练,以自主通用 GPU 产品更好支持国内大模型创新应用,进一步夯实我国算力基础,助力人工智能产业自主生态建设。